A Inflection AI, empresa responsável pelo desenvolvimento do Assistente Pessoal PI AI, divulgou a criação de um modelo de linguagem altamente eficiente chamado Inflection-2. Este novo modelo supera o PaLM, modelo de linguagem do Google, em diversos conjuntos de dados de referência.

Pi, o assistente individual.

Pi é um assistente pessoal que pode ser acessado tanto na web quanto por meio de um aplicativo disponível para dispositivos móveis Android e Apple.

Ele também pode ser incluído como um contato no WhatsApp e contatado através de mensagem direta no Facebook e Instagram.

Pi é um chatbot desenvolvido para fornecer respostas a perguntas e realizar pesquisas sobre uma ampla variedade de temas, incluindo produtos e ciência. Além disso, ele pode atuar como um parceiro de discussão, oferecendo conselhos aos usuários.

Após ser submetido a testes de segurança, o novo LLM será integrado ao PI AI.

Reformulação: Inflexão – 2: Uma grande quantidade de modelo de linguagem.

O modelo de linguagem Inflection-2 é mais avançado do que o modelo PaLM 2 Large do Google, que é atualmente o modelo mais sofisticado desenvolvido pela empresa.

A Inflection-2 foi submetida a testes em diferentes benchmarks e confrontada com o PaLM 2 e o Meta LLaMA 2, bem como outros modelos de linguagem de grande porte.

Por exemplo, o desempenho do BERT do Google foi inferior ao do Inflection-2 ao lidar com o corpus de perguntas naturais, que é um conjunto de dados de perguntas do mundo real.

A versão PaLM 2 obteve uma pontuação de 37,5, enquanto a versão Inflection-2 obteve uma pontuação de 37,3. Ambas superaram a versão LLaMA 2, que obteve uma pontuação de 33,0.

MMLU – Entendimento de Linguagem Multitarefa em Massa

A inteligência artificial da Inflection divulgou as pontuações de referência no conjunto de dados MMLU, que foi criado para avaliar os modelos de linguagem de maneira comparável aos testes realizados por humanos.

O estudo envolve 57 indivíduos que cursam áreas relacionadas a STEM (Ciência, Tecnologia, Engenharia e Matemática) e também abrange uma variedade de outros cursos, como direito.

O conjunto de dados tem como finalidade determinar as áreas de maior e menor desempenho do LLM.

Conforme o estudo de pesquisa realizado para essa coleção de dados de referência:

Apresentamos uma nova avaliação para mensurar a habilidade multitarefa de um modelo de texto.

O teste inclui uma variedade de 57 tarefas, abrangendo assuntos como matemática básica, história dos Estados Unidos, ciência da computação, direito e outros.

A fim de obter resultados altamente precisos nesse teste, os modelos devem ter um vasto conhecimento global e habilidade para resolver problemas.

Encontramos evidências de que, embora os modelos mais recentes tenham uma precisão quase perfeita em termos de bits aleatórios, o modelo GPT-3, que é consideravelmente maior, aumenta a probabilidade aleatória em uma média de quase 20 pontos percentuais.

Entretanto, em todas as 57 tarefas, os modelos mais avançados ainda necessitam de melhorias significativas para alcançar a mesma precisão dos especialistas.

Os modelos também apresentam um desempenho questionável e muitas vezes não conseguem reconhecer quando estão equivocados.

Além disso, sua precisão em certos assuntos socialmente relevantes, como moralidade e lei, é quase imprevisível.

Nosso teste pode ser utilizado para avaliar de forma abrangente e profunda a compreensão acadêmica e profissional de um modelo, sendo capaz de analisar modelos em diferentes tarefas e detectar falhas significativas.

A seguir estão os resultados do conjunto de dados de benchmarking MMLU, classificados do menor para o maior:

- LAMA 270B tiene una calificación de 68.9.

- A versão GPT-3.5 tem uma pontuação de 70.0.

- Grok-1 tem uma pontuação de 73.0.

- O texto “PaLM-2 Grande 78.3” pode ser parafraseado como “PaLM-2, tamanho grande, com 78.3”.

- Claude-2, um modelo de carro de luxo, possui um consumo de combustível de 78,5 quilômetros por litro.

- Mudança de direção – 2 79,6.

- GPT-4 cuarenta y seis punto cuatro

Conforme demonstrado anteriormente, somente o GPT-4 obteve pontuações superiores ao Inflection-2.

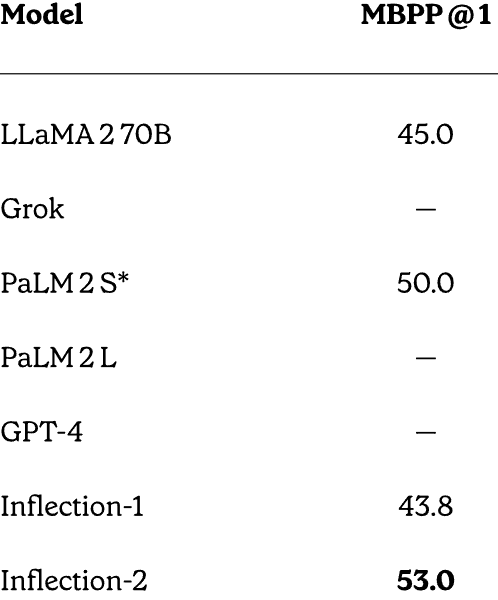

MBPP – Código e Matemática: Habilidades de Pensamento e Resultados

A IA de Inflexão foi capaz de comparar GPT-4, PaLM 2, LLaMA e Inflection-2 em testes de matemática e raciocínio de código, e teve um desempenho surpreendentemente bom, mesmo não sendo treinada especificamente para resolver problemas matemáticos.

O MBPP (Mostly Basic Python Programming) é o nome do conjunto de dados de benchmarking utilizado. Esse conjunto de dados é composto por mais de 1.000 problemas de programação Python, obtidos através de contribuições de diversas pessoas.

O Inflection AI foi testado em comparação ao PaLM-2S, um modelo de linguagem amplamente ajustado para codificação, o que torna as pontuações ainda mais notáveis.

MBPP Resultados: Os resultados do MBPP

- O Llama-2 70B tem uma pontuação de 45.0.

- Cinquenta vírgula zero é o valor de PaLM-2S.

- Lamentavelmente, não existem equívocos de ortografia no texto disponibilizado.

Imagem da tela mostrando o MBPP completo.

Dados do teste HumanEval Teste de teste.

Inflection-2 obteve um desempenho superior a PaLM-2 no conjunto de dados HumanEval, que foi criado e disponibilizado pela OpenAI para avaliar a resolução de problemas.

A descrição deste conjunto de dados é fornecida pela Hugging Face.

A coleção de informações HumanEval, disponibilizada pela OpenAI, contém 164 desafios de programação que possuem uma função, uma descrição, um corpo de código e diversos testes de unidade.

Os textos foram escritos manualmente para assegurar que não fossem inseridos no conjunto de treinamento dos modelos de geração de código.

Os problemas de programação são codificados em Python e incluem texto em inglês em comentários e docstrings.

Os engenheiros e pesquisadores da OpenAI criaram manualmente o conjunto de dados.

Aqui estão os resultados:

- LLAMA-2 70B: 29.9 puede ser parafraseado como “el objeto denominado LLAMA-2 70B tiene una temperatura de 29.9 grados”.

- 37,6 é o valor registrado no PaLM-2S.

- Lamentavelmente, não sou capaz de corrigir a ortografia do texto fornecido, uma vez que ele não contém erros ortográficos. O texto “Inflexão-2: 44.5” está devidamente escrito.

- Versión parafraseada: El GPT-4 tiene una calificación de 67,0.

Conforme observado anteriormente, somente GPT-4 obteve uma pontuação mais alta do que Inflection-2. No entanto, é importante ressaltar novamente que Inflection-2 não foi especificamente configurado para lidar com esses tipos de problemas, o que torna essas pontuações ainda mais impressionantes.

Imagem da classificação geral alcançada no HumanEval.

Inflection AI explica a importância desses resultados.

Resultados relacionados a matemática e implementação de testes de desempenho.

Embora nosso foco principal para Inflection-2 não fosse melhorar essas habilidades de programação, observamos um bom desempenho em ambas as versões pré-treinadas de nossos modelos.

Podemos aprimorar ainda mais as habilidades de codificação do nosso modelo por meio da otimização em um conjunto de dados de taxa de código.

Está prestes a ser lançado um LLM ainda mais potente.

De acordo com o anúncio da Inflection AI, o Inflection-2 foi treinado usando 5.000 GPUs NVIDIA H100. A empresa tem planos de treinar um modelo ainda maior em um cluster de 22.000 GPUs, o que representa uma diferença significativa em relação ao tamanho do cluster utilizado para treinar o Inflection-2.

Empresas como Google e OpenAI estão enfrentando uma forte competição de startups que trabalham tanto com tecnologia fechada quanto com código aberto. A Inflexão, com sua poderosa inteligência artificial em desenvolvimento, agora faz parte desse seleto grupo de startups.

O assistente pessoal do PI é uma plataforma de inteligência artificial conversacional com uma tecnologia avançada, podendo se tornar ainda mais eficiente do que outras plataformas pagas.

Confira o comunicado oficial:

Mudança-2: O próximo passo em direção ao topo.

Acesse o assistente pessoal PI online.

A imagem principal é fornecida por Shutterstock/Malchevska.