Os cientistas conduziram um experimento para verificar se um modelo de IA poderia detectar o seu próprio conteúdo, devido ao uso dos mesmos conjuntos de dados para treinamento. Surpreendentemente, descobriram que um dos três modelos de IA produziu um conteúdo tão imperceptível que nem mesmo a própria IA que o gerou poderia detectá-lo.

A pesquisa foi conduzida por acadêmicos da Southern Methodist University, no Departamento de Ciência da Computação da Lyle School of Engineering.

IA para detecção de conteúdo

Muitos detectores de IA são programados para identificar os indícios de histórias geradas por IA. Esses indícios são conhecidos como “artefatos” e surgem como resultado da tecnologia inovadora por trás delas. No entanto, existem também outros artefatos que são exclusivos para cada modelo de base (o modelo de linguagem em que a IA é fundamentada).

Esses objetos são exclusivos para cada inteligência artificial e são gerados a partir de dados de treinamento e ajustes específicos, que são sempre diferentes de um modelo de IA para outro.

Os pesquisadores encontraram provas de que é essa característica única que possibilita que uma inteligência artificial tenha um maior êxito ao identificar seu próprio conteúdo, em comparação com a tentativa de identificar o conteúdo gerado por outra IA.

Bard tem uma maior probabilidade de reconhecer o conteúdo criado por Bard, enquanto o ChatGPT tem uma taxa de sucesso mais elevada na identificação do conteúdo gerado pelo ChatGPT, no entanto…

Os pesquisadores encontraram evidências de que essa afirmação não se aplicava ao conteúdo criado por Claude. Claude teve dificuldade em reconhecer o conteúdo que ele mesmo gerou. Os pesquisadores têm uma teoria sobre o motivo pelo qual Claude não conseguiu identificar seu próprio conteúdo, e este artigo explora essa questão com mais detalhes.

A intenção por trás dos testes de pesquisa é a seguinte:

Devido às diferentes formas de treinamento de cada modelo, é desafiador desenvolver uma ferramenta de detecção capaz de identificar os artefatos gerados por todas as diversas ferramentas de Inteligência Artificial generativa.

Neste contexto, foi adotada uma abordagem alternativa denominada autodetecção, na qual o modelo generativo é utilizado para identificar e diferenciar os artefatos gerados por si próprio do texto produzido por seres humanos.

Uma possível reescrita do texto seria: “Uma vantagem disso seria não termos a necessidade de aprender a identificar todos os modelos de IA generativa, apenas precisaríamos ter acesso a um modelo de IA generativa para essa detecção.”

Isso é uma vantagem significativa em um cenário em que constantemente novos modelos estão sendo desenvolvidos e treinados.

Confira: O Google explica como o Googlebot trata conteúdo produzido por inteligência artificial.

Assim sendo, a metodologia desempenha um papel crucial em todos os projetos, uma vez que possibilita que o investigador estruture e realize suas tarefas de maneira ordenada e minuciosa.

Os cientistas realizaram experimentos com três diferentes modelos de IA.

- Texto: Chat de GPT-3.5 desarrollado por OpenAI

- Bardo através do Google.

- “Antropik’s creation, Claude.”

Foram usadas as versões de setembro de 2023 de todos os modelos utilizados.

Foi gerado um conjunto de informações sobre cinquenta assuntos distintos. Cada modelo de inteligência artificial recebeu os mesmos estímulos para produzir ensaios de aproximadamente 250 palavras para cada um dos cinquenta temas, resultando em cinquenta ensaios para cada um dos três modelos de IA.

Cada modelo de IA foi, em seguida, requisitado de maneira igual para parafrasear seu próprio conteúdo e criar um novo ensaio, que consistia em uma reformulação de cada ensaio original.

Eles também reuniram cinquenta ensaios humanos produzidos em cada um dos cinquenta tópicos. Todos os ensaios humanos selecionados foram obtidos da BBC.

Posteriormente, os especialistas utilizaram a instrução de nível zero para identificar automaticamente o conteúdo produzido pela inteligência artificial.

A técnica de zero-shot prompting se baseia na habilidade dos modelos de IA de realizar tarefas para as quais não foram treinados explicitamente.

Os pesquisadores aprofundaram a explicação de sua metodologia.

“Fazemos o processo de criar uma nova instância de cada sistema de IA, iniciando-o com uma consulta específica: ‘Se o texto a seguir corresponder ao seu estilo de escrita e escolha de palavras.’ Realizamos esse procedimento novamente para os ensaios originais, parafraseados e humanos, e anotamos os resultados.”

Além disso, incluímos o resultado da ferramenta ZeroGPT de detecção de IA. Embora não tenhamos usado esse resultado para fins de comparação de desempenho, ele serve como uma base para ilustrar o quão desafiadora é a tarefa de detecção.

Também foi notado por eles que uma taxa de acerto de 50% é o mesmo que simplesmente adivinhar, o que pode ser considerado basicamente um nível de precisão insatisfatório.

Resultados: Deteção automática.

É importante destacar que os pesquisadores admitiram que a quantidade de amostras utilizadas foi limitada e afirmaram que não estão fazendo afirmações conclusivas sobre os resultados.

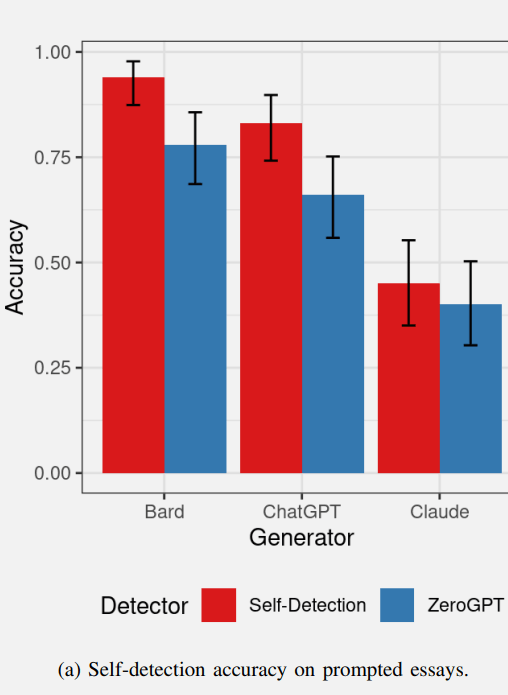

Aqui está uma representação visual das taxas de sucesso da detecção automática de IA nos primeiros testes. Os valores em vermelho indicam a taxa de autodetecção da IA, enquanto os valores em azul representam o desempenho da ferramenta de detecção de IA ZeroGPT.

Resultados da detecção automática de inteligência artificial de conteúdo de texto próprio.

Bard teve um bom desempenho ao identificar seu próprio conteúdo, e o ChatGPT também obteve um resultado positivo ao detectar seu próprio conteúdo.

A ferramenta de detecção de IA ZeroGPT teve um bom desempenho na detecção do conteúdo “Bard”, mas teve um desempenho um pouco inferior na detecção do conteúdo “ChatGPT”.

O ZeroGPT falhou em identificar efetivamente o conteúdo produzido por Claude, apresentando um desempenho inferior ao limite de 50%.

Claude se destacou no grupo por não conseguir identificar seu próprio conteúdo, obtendo resultados significativamente inferiores aos de Bard e ChatGPT.

Os pesquisadores sugeriram que talvez a saída de Claude possa conter artefatos menos perceptíveis, o que explicaria por que Claude e ZeroGPT não conseguiram identificar os ensaios de Claude como gerados por IA.

Dessa forma, mesmo que Claude não pudesse identificar por si mesmo seu próprio conteúdo, isso indicava que a produção de Claude era de melhor qualidade, resultando em menos artefatos de IA.

A detecção de conteúdo gerado por Bard foi mais eficiente do que a detecção de conteúdo gerado por ChatGPT e Claude no ZeroGPT. Os pesquisadores levantaram a hipótese de que isso ocorreu porque Bard produz artefatos mais evidentes, o que facilita sua identificação.

Assim, em relação ao conteúdo de autodetecção, pode-se dizer que Bard está produzindo artefatos que são mais facilmente detectáveis, enquanto Claude está produzindo artefatos que são menos detectáveis.

Resultados: Identificando automaticamente conteúdo parafraseado.

Os pesquisadores levantaram a questão de se os modelos de IA seriam capazes de identificar automaticamente o texto que foi parafraseado, pois os elementos gerados pelo modelo (como observado nos testes originais) também devem estar presentes no texto reescrito.

Os pesquisadores admitiram que as instruções para escrever o texto e parafraseá-lo são distintas, já que cada reescrita difere do texto original. Isso pode resultar em detecções próprias diferentes para o texto parafraseado.

As conclusões obtidas ao realizar a autodetecção do texto reescrito foram, de fato, distintas das obtidas ao realizar a autodetecção do teste de redação original.

- Bard conseguiu identificar automaticamente o texto parafraseado com uma taxa parecida.

- O ChatGPT não conseguiu identificar automaticamente o texto parafraseado em uma taxa significativamente maior do que 50% (que é basicamente adivinhação).

- O desempenho do ZeroGPT foi comparável aos resultados observados no teste anterior, apresentando uma pequena queda de desempenho.

Possivelmente, a descoberta mais intrigante foi feita por Claude de Anthropic.

Claude pôde reconhecer o conteúdo parafraseado por conta própria (mas não conseguiu identificar o ensaio original no teste anterior).

É curioso notar que os ensaios originais de Claude tinham tão poucos elementos artificiais que indicassem que eram produzidos por inteligência artificial, que até mesmo Claude não conseguiu identificá-los.

No entanto, ZeroGPT não tinha a capacidade de identificar a própria parafrase, ao contrário.

Neste experimento, os pesquisadores fizeram um comentário.

É bastante interessante observar que a capacidade de autodetecção do ChatGPT é afetada pela parafraseagem, ao contrário da capacidade de autodetecção de Claude. Isso pode ser explicado pelas diferenças internas de funcionamento desses dois modelos transformadores.

Captura de tela de um sistema de inteligência artificial capaz de identificar e reescrever conteúdo de forma paráfrase.

Esses experimentos tiveram resultados surpreendentes, especialmente ao avaliar o desempenho do modelo de Inteligência Artificial em detectar o conteúdo de outros modelos, o que apresentou uma peculiaridade interessante.

Resultados: Inteligência Artificial identificando todos os tipos de conteúdo de outros.

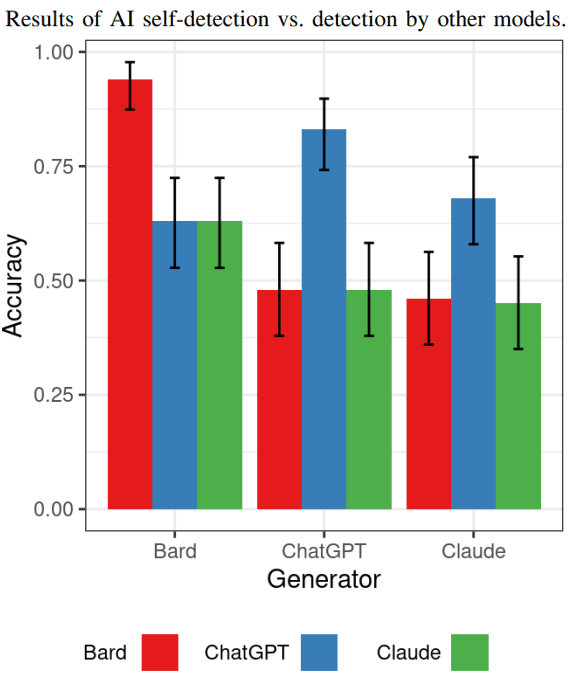

O teste seguinte avaliou o desempenho de cada modelo de IA na identificação do conteúdo produzido pelos demais modelos de IA.

Se for comprovado que o Bard produz uma quantidade maior de artefatos em comparação aos outros modelos, os demais modelos serão capazes de identificar facilmente o conteúdo gerado pelo Bard?

Os resultados indicam que, de fato, os outros modelos de IA têm maior facilidade em detectar o conteúdo produzido pelo Bard.

Em relação à detecção, o ChatGPT produziu conteúdo que tanto Claude quanto Bard não conseguiram identificar como sendo gerado por inteligência artificial (assim como Claude também não foi capaz de identificá-lo).

ChatGPT foi capaz de identificar o conteúdo produzido por Claude com uma taxa de acerto maior do que tanto Bard quanto Claude, no entanto, a diferença na taxa de acerto não era significativamente melhor do que simplesmente adivinhar.

A descoberta feita aqui é que todos eles não possuíam uma habilidade tão boa em identificar o conteúdo um do outro, o que levou os pesquisadores a considerarem que a autodeteção é um campo de estudo com potencial.

Aqui está o gráfico que ilustra os dados obtidos neste teste em particular.

Neste momento, é importante destacar que os pesquisadores não afirmam que esses resultados são definitivos em relação à detecção de IA de modo geral. O objetivo da pesquisa foi testar se os modelos de IA poderiam detectar com sucesso o conteúdo que eles mesmos geram. Em sua maioria, a resposta é sim, eles têm um desempenho melhor na autodetecção, mas os resultados são semelhantes aos encontrados com ZEROGpt.

Os especialistas fizeram observações a respeito:

A capacidade de detecção própria apresenta resultados semelhantes ao ZeroGPT, porém é importante ressaltar que o objetivo deste estudo não é afirmar que a autodetecção é superior a outros métodos. Para essa afirmação seria necessário um estudo mais amplo, comparando com diversas ferramentas avançadas de detecção de conteúdo de inteligência artificial. Neste estudo, apenas investigamos a capacidade básica dos modelos de detecção automática.

Conclusões e decisões tomadas

A comprovação dos resultados do teste revela que identificar material produzido pela inteligência artificial não é uma tarefa simples. BARD tem a habilidade de identificar tanto o seu próprio conteúdo quanto conteúdo que foi reescrito.

O ChatGPT é capaz de identificar o seu próprio conteúdo, porém tem um desempenho inferior quando se trata de conteúdo parafraseado.

Claude se destaca por sua incapacidade de identificar seu próprio conteúdo, mas conseguiu identificar o conteúdo reescrito, o que foi um pouco estranho e surpreendente.

Foi um desafio identificar os ensaios originais de Claude e os ensaios reescritos para o ZeroGPT e outros modelos de IA.

Os resultados de Claude foram observados pelos pesquisadores.

Este resultado que parece não ter uma conclusão clara necessita de uma análise mais aprofundada, pois é influenciado por duas causas interligadas.

1) A habilidade do modelo em produzir texto com poucos defeitos perceptíveis. Visto que esses sistemas buscam gerar texto que pareça humano, a existência de poucos defeitos, especialmente aqueles difíceis de detectar, indica que o modelo está se aproximando desse objetivo.

A capacidade intrínseca do modelo de auto detecção pode ser influenciada pela arquitetura utilizada, pela frase de estímulo e pelo ajuste fino realizado.

Os cientistas fizeram uma observação adicional sobre Cláudio.

Apenas Cláudio não pode ser identificado. Isso sugere que Cláudio pode criar menos objetos detectáveis em comparação aos outros modelos.

A taxa de autodetecção segue uma tendência semelhante, sugerindo que Claude produz texto com menos imperfeições, o que torna mais desafiador diferenciá-lo da escrita realizada por humanos.

No entanto, é curioso notar que Claude não conseguiu reconhecer seu próprio conteúdo original, ao contrário dos outros dois modelos que tiveram mais sucesso nessa tarefa.

Os especialistas enfatizaram que a investigação sobre autodetecção é um campo promissor que merece mais estudos. Eles sugerem que futuras pesquisas se concentrem em conjuntos de dados mais amplos e variados, com textos gerados por IA, testem modelos adicionais de IA, comparem com mais detectores de IA e explorem como a engenharia rápida pode afetar a eficácia da detecção.

Confira o artigo de pesquisa completo e o resumo nesta fonte.

IA de auto detecção de conteúdo para modelos de linguagem baseados em transformadores.

A imagem principal é fornecida por Shutterstock/SObeR 9426.